Es ist die größte Algorithmus-Änderung seit fünf Jahren und betrifft jede zehnte Suchanfrage: Mit dem Google BERT Update will Google das Verständnis von komplexen Long-Tail-Suchanfragen verbessern und relevantere Ergebnisse anzeigen. Mithilfe von Natural Language Processing kann Google jetzt den semantischen Kontext einer Suchanfrage viel besser verstehen. Auch in Deutschland ist das BERT Update schon ausgerollt – zumindest für die Ermittlung der Featured Snippets.

Übrigens: Alle relevanten News über Google Updates und andere SEO-Themen gibt’s in unserem Newsletter – jetzt kostenlos anmelden:

Nichts mehr verpassen in SEO & Marketing!

Kurzeinschätzung zum Google Bert Update

BERT ist eine konsequente Weiterentwicklung von Panda, Hummingbird und Rank Brain. Allerdings geht es diesmal nicht darum, wie Daten indexiert oder gerankt werden. Vielmehr versucht Google den Kontext innerhalb einer Suchanfrage zu erkennen und passende Ergebnisse zu liefern. Das ist eine spannende Ergänzung dessen, was kontextfreie Modelle wie Word2Vec und GloVe leisten können. Besonders für Voice Search und Conversational Search sehe ich bei konsequenter Anwendung in der nahen Zukunft große Qualitätssprünge. Malte Landwehr, VP Product, Searchmetrics

Ist das Google BERT Update in Deutschland ausgerollt?

War BERT anfangs nur für die organischen Suchergebnisse bei Google.com im Einsatz, erfolgt seit Anfang Dezember 2019 der weltweite Rollout von BERT für mehr als 70 Sprachen, darunter auch Deutschland. Die Rollout-Historie von BERT im Überblick.

- Initialer Rollout von BERT für Google.com und Featured Snippets am 24. Oktober 2019: Zum Start sei das BERT Update für die Ermittlung der US-Suchergebnisse von Google.com ausgerollt worden und betreffe jede zehnte Suchanfrage , so Pandu Nayak, Vice President Search bei Google, in einem Blogpost. Für Featured Snippets, die über den organischen Suchergebnissen als Position 0 mit Text, Tabelle oder Liste ausgespielt werden, wurde BERT – so erklärte es Danny Sullivan via Twitter – schon in allen 25 Sprachen genutzt, für die Google auch Featured Snippets anzeigt, also auch in Deutschlan.

- Weltweiter Rollout seit dem 9. Dezember 2019: Inzwischen wird BERT weltweit für mehr als 70 Sprachen ausgerollt, um die organischen Suchergebnisse zu ermitteln. Auch der deutsche Index Google.de ist von den BERT-Änderungen betroffen.

- In welchen Länder wird BERT ausgerollt? BERT is rolling out for: Afrikaans, Albanian, Amharic, Arabic, Armenian, Azeri, Basque, Belarusian, Bulgarian, Catalan, Chinese (Simplified & Taiwan), Croatian, Czech, Danish, Dutch, English, Estonian, Farsi, Finnish, French, Galician, Georgian, German, Greek, Gujarati, Hebrew, Hindi, Hungarian, Icelandic, Indonesian, Italian, Japanese, Javanese, Kannada, Kazakh, Khmer, Korean, Kurdish, Kyrgyz, Lao, Latvian, Lithuanian, Macedonian Malay (Brunei Darussalam & Malaysia), Malayalam, Maltese, Marathi, Mongolian, Nepali, Norwegian, Polish, Portuguese, Punjabi, Romanian, Russian, Serbian, Sinhalese, Slovak, Slovenian, Spanish Swahili, Swedish, Tagalog, Tajik, Tamil, Telugu, Thai, Turkish, Ukrainian, Urdu, Uzbek & Vietnamese.

In diesem Tweet kündigte Google den globalen Rollout an:

BERT, our new way for Google Search to better understand language, is now rolling out to over 70 languages worldwide. It initially launched in Oct. for US English. You can read more about BERT below & a full list of languages is in this thread…. https://t.co/NuKVdg6HYM

— Google SearchLiaison (@searchliaison) December 9, 2019

Inzwischen hat sich auf Webmaster Trends Analyst John Mueller in einem seiner Google Webmaster Hangouts zu Wort gemeldet, nachdem ein Nutzer von 40% Traffic-Rückgang berichtetet und BERT als Ursache vermutete. Mueller erklärte, dass BERT nicht für solche gravierende Rankings- und Traffic-Rückgänge verantwortlich sei, sondern eines der regulären Updates bzw. ein Core Update. Nach welchen Kriterien die Algorithmus-Änderungen vorgenommen werden, erklärt Mueller ab 30:46 Minuten im Video:

Was bedeutet BERT?

Die Abkürzung BERT steht für Bidirectional Encoder Representations from Transformers und bezeichnet ein Algorithmus-Modell, das auf neuronalen Netzwerken basiert. Mithilfe des Natural Language Processing (NLP) versuchen maschinelle Systeme, die Komplexität menschlicher Sprache angemessen nachzuvollziehen. Eine sehr gute, ausführliche Dokumentation über BERT findet ihr im Google AI Blog.

Etwas einfacher ausgedrückt: Mithilfe von BERT versucht Google, den Kontext einer Suchanfrage besser zu verstehen sowie die einzelnen Wörter noch besser im Zusammenhang zu deuten. Dieser Durchbruch basiert auf Rechenmodellen namens Transformers: Sie setzen ein Wort in Beziehung zu allen anderen Wörtern in einem Satz und verfolgen nicht nur die Bedeutung Wort für Wort. Dies gilt vor allem für das Verständnis von Präpositionen sowie von der Position einzelner Wörter innerhalb einer Suchanfrage.

Warum ist das BERT-Update so wichtig für Google?

Laut Google werden rund 15 Prozent aller täglichen Suchanfragen zum ersten Mal gestellt. Zudem werden die Suchanfragen immer ähnlicher der menschlichen, realen Kommunikation – auch bedingt durch technische Entwicklungen wie Voice Search. Der Statistik-Dienst Comscore erwartet, dass der Anteil von Voice Search in zwei Jahren bei 50 Prozent liegt. Zudem werden Suchanfragen immer länger – schon jetzt können 70 Prozent der Suchanfragen dem Long-Tail-Bereich zugeordnet werden. Menschen wollen von Google die möglichst präzise Antwort auf ganze Fragesätzen haben, und das in Sekundenbruchteilen – an der dahinterstehenden Technik hat nun auch BERT einen gehörigen Anteil.

Google arbeitet deshalb schon seit vielen Jahren an neuronalen Netzwerken, die in der Lage sind, komplexe Suchanfragen noch besser zu verstehen.

- Hummingbird: 2013 wurde Hummingbird Teil des Google-Algorithmus. Diese Algorithmus-Änderung konnte nun die gesamte Suchanfrage besser interpretieren und nicht nach einzelnen Wörtern innerhalb der Suchanfrage suchen.

- RankBrain: 2015 wurde RankBrain zum Google-Algorithmus hinzugefügt und zum drittwichtigsten Google Ranking-Faktor erklärt. Damit wurde die Verarbeitung von mehrdeutigen und komplexen Suchanfragen, die über eine Longtail-Suche hinausgehen, ermöglicht. Ebenfalls kann RankBrain erstmalig gestellten Suchanfragen sowie Umgangssprache, Dialoge oder Wortschöpfungen besser verarbeiten.

Welche Suchanfragen betrifft BERT?

Grundsätzlich betrifft BERT Long-Tail-Suchanfragen. Hier kann BERT den Kontext einer längeren Suchanfrage, die als Frage oder Wortgruppe in die Suchleiste eingetippt oder als sprachbasierte Suchanfrage gesprochen wird, besser verstehen.

Google selbst hat im erwähnten Blogpost einige Beispiele für Suchanfragen gegeben, die mithilfe von BERT besser vom Algorithmus verstanden werden können und entsprechende Ergebnisse liefern.

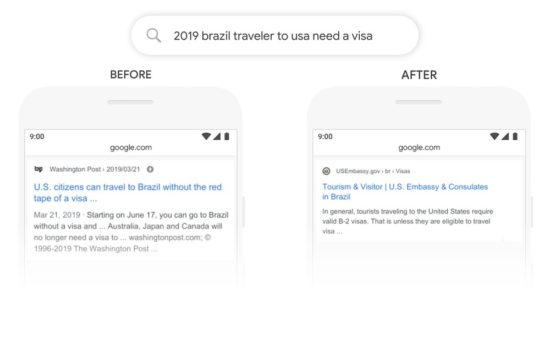

Beispiel 1: “2019 brazil traveler to usa need a visa”

In diesem Beispiel für ein organisches Suchergebnis, so erklärt es Google, sei bislang das Wort “to” und die Beziehung zu den anderen Wörtern in der Suchanfrage unterschätzt worden. Allerdings sei es elementar für das Verständnis – schließlich gehe es um eine Person aus Brasilien, die in die USA reisen möchte, und nicht etwa umgekehrt. Das neue BERT-Modell erlaube es Google nun, die Suchanfrage korrekt entsprechend der tatsächlichen Suchintention zu beantworten.

In diesem Beispiel für ein organisches Suchergebnis, so erklärt es Google, sei bislang das Wort “to” und die Beziehung zu den anderen Wörtern in der Suchanfrage unterschätzt worden. Allerdings sei es elementar für das Verständnis – schließlich gehe es um eine Person aus Brasilien, die in die USA reisen möchte, und nicht etwa umgekehrt. Das neue BERT-Modell erlaube es Google nun, die Suchanfrage korrekt entsprechend der tatsächlichen Suchintention zu beantworten.

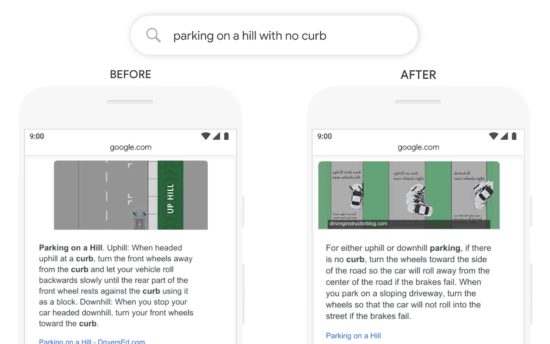

Beispiel 2: “Parking on a hill with no curb”

In diesem Beispiel für die Ermittlung des passenden Featured Snippets, so erklärt Google es im Blogpost, habe der Algorithmus in der Vergangenheit zu sehr auf das Wort “curb” geschaut – dabei sei das Wort “no” ignoriert worden. Entsprechend sei ein Featured Snippet ausgespielt worden, das wenig hilfreich war, da es das genaue Gegenteil dessen aussagte, was eigentlich hinter der Suchanfrage steckt.

Was können SEOs und Webmaster tun?

Hierfür gibt es keine umfassende Antwort. Es gibt keine einfachen Taktiken, mit denen eine Website plötzlich viel besser rankt oder Verluste aufgegangen werden können. Stattdessen ist enorm wichtig, nicht für einen Algorithmus zu schreiben, sondern für die Menschen und potenziellen Nutzer und Käufer, die eine Website auch tatsächlich besuchen und mit ihr interagieren.