Das Jahr 2016 hat gleich mit einem von Google bestätigten Update begonnen. Dabei handelt es sich entgegen ersten Vermutungen aber nicht um Panda oder Penguin, sondern eine Änderung im Kern des Ranking-Algorithmus. Wir haben uns die frischen Daten in der Research Cloud genauer angeschaut.

Google Update: Hintergrund

Eigentlich war zum Jahresbeginn 2016 ein Penguin-Update erwartet worden. Deshalb gingen die ersten Analysen am Wochenende des 9./10. Januar 2016 von einem entsprechenden Update aus. Die Schwankungen in den Google-Rankings waren global hoch, hierbei kamen verschiedene Dienste, die Veränderungen in den Google Suchergebnissen messen, zum gleichen Ergebnis.

Inzwischen haben sich mehrere Google-Mitarbeiter via Twitter zu Wort gemeldet: John Mueller und Gary Illyes bestätigten, dass es sich bei den beobachteten Schwankungen um ein Google-Update handelte. Allerdings nicht das erwartete Penguin-Update, sondern eine Änderung im Kern des Ranking-Algorithmus.

Content-Qualität und User Intent entscheidend

Wir haben die Research-Daten in der Searchmetrics Suite noch einmal frisch gezogen, um Veränderungen in den Google-Suchergebnissen analysieren zu können. Auch uns sind dabei massive Veränderungen in den Top100-Websites nach SEO Visibility aufgefallen. Nach dem Update finden sich jetzt 50 Prozent andere Webseiten bei den Gewinnern bzw. Verlierern. Dies gilt sowohl für google.de als auch google.com. Ebenfalls sind diese Veränderungen sowohl in Desktop- als auch mobilen Suchergebnissen zu beobachten. Wir haben versucht, einige Muster zu erkennen, die für ein Qualitäts-Update sprechen. Einige Aspekte möchte ich euch jetzt vorstellen.

Content-Qualität und QDF

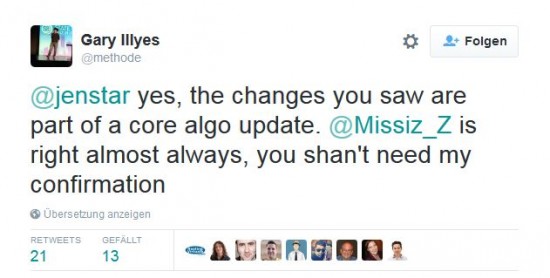

Bereits für das letzte Update 2015 – das Phantom 3 / Quality Update – haben wir die Volatilität der Suchergebnisse angemerkt. Dies ist auch anhand der aktuellen Daten ablesbar: Insbesondere in den USA haben Publisher-Websites mit Beiträgen zu Marken-Keywords bzw. Entitäten stark verloren. Dies ist in Deutschland so nicht zu beobachten; der Grund dafür könnte sein, dass das globale Update noch nicht komplett ausgerollt worden ist.

Schauen wir uns den US-Hauptverlierer in den aktuellen Daten an – theatlantic.com. Der Publisher hat vor allem zu Brand-Keywords und Entitäten verloren:

Auffällig ist, dass viele Verlierer-Domains klassische Print-Publisher sind – und deren Rankings vor allem bei älteren Beiträgen verloren gingen. Die Verluste auf Publisher-Seite wurden primär durch die entsprechenden Brands ausgeglichen, die ihre Rankings teilweise zurückgewonnen haben. Beispiele für Gewinner-Brands sind audi.de (schwankt seit September), villeroy-boch.com (schwankt ebenfalls schon länger auf und ab), telekom.de (zum Thema E-Mail), alaskaair.com und yamaha-motor.eu.

Gleichzeitig haben vor allem bei google.com auch einige Publisher gewonnen – vor allem mit aktuelleren oder holistischen Inhalten. In den USA ist gq.com der größte Gewinner nach dem Update – deren größte Gewinner-URL ist ein umfangreicher Artikel über Football-Spieler Tom Brady (siehe Screenshot).

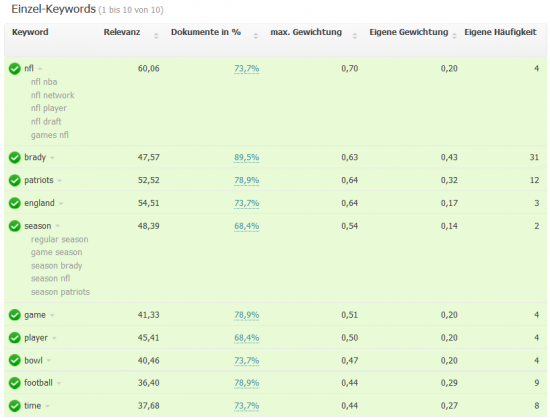

Der Beitrag entählt neben einem Video und zahlreichen Fotos extrem viel textuellen Content – mehr als 3.000 Wörter über den Football-Star, darunter auch ein Interview. Ein Test mit der Content Optimization in der Searchmetrics Suite zeigt zudem, dass der Artikel alle wichtigen Sub-Topics zur Entität Tom Brady abdeckt:

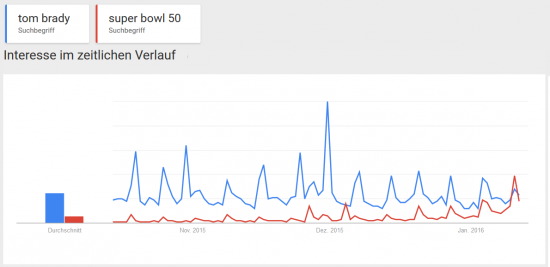

Ob für ein bestimmtes Keyword eher Brands oder Publisher gewinnen, hängt stark vom individuellen QDF-Score (Query Deserves Freshness) ab, den Google anhand der Nachrichtenlage und des Nutzerverhaltens, insbesondere des Suchvolumens, ermittelt. Für Themen, die aktuell in den News sind, gewinnen natürlich eher die Publisher mit aktuellen Inhalten. Dies könnte auch im Fall Tom Brady zutreffen, da der Jahresbeginn traditionell von der Superbowl-Saison geprägt ist.

User Intent statt Content

Aus SEO-Sicht ist eine Gruppe von Gewinner-Seiten etwas überraschend: Educational Games. Domains wie brainpop.com oder mathplayground.com haben zugelegt und konnten ihre Positionen, die sie in der Vorwoche verloren hatten, zurückgewinnen. Das Ganze übrigens mit Seiten wie dieser:

Der Screenshot ist nicht abgeschnitten, das ist tatsächlich die gesamte Seite. Für alle, die jetzt Cloaking vermuten – auch der Google Cache ist erstaunlich leer:

Aus klassischer SEO-Sicht lassen sich diese Rankings kaum nachvollziehen. Hier kann es nur eine Erklärung geben: Nutzer-Signale! Wenn jemand nach “how to write a sentence” sucht und auf einem solchen Lernspiel landet, kann das durchaus die Suchintention erfüllen. Und durch die Art des Inhalts (interaktives Spiel) ist mit einer überdurchschnittlich langen Verweildauer auf der Seite zu rechnen. Laut SimilarWeb dauert ein Besuch bei BrainPOP im Schnitt mehr als 8 Minuten; bei unter 20% Bounce Rate!

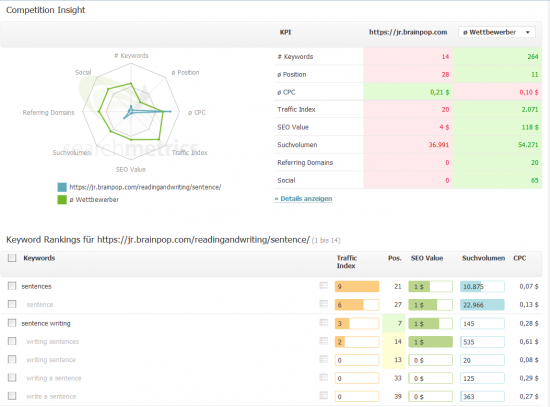

Dennoch sieht man anhand von BrainPOP den großen Nachteil solcher fast content-losen Seiten. Sie ranken, anders als holistische Dokumente, die für mehrere Tausend Suchbegriffe ranken können, nur für sehr wenige Keywords. Hier wird Traffic (auch) über die Masse an Inhalten generiert.

Fazit zum Update: Qualitativ hochwertige Inhalte, die Themen ganzheitlich behandeln, sind bei viele Themen die Gewinner. Doch nicht die bloße Menge des Contents ist entscheidend für das Ranking, sondern die Frage, ob die Inhalte relevant sind für die Erfüllung der Nutzerintention.

Wir wollen noch kurz einige Schwankungen in den Suchergebnissen betrachten, die nicht direkt diesem Core Update zugeordnet werden können.

Deindexierte Gitarrenseiten

Webseiten, die Tabs (Noten) für Gitarren anbieten, haben nicht nur Visibility verloren, sondern sind deindexiert worden. Schauen wir uns beispielhaft die Visibility von ultimate-guitar.com in Deutschland an:

Diese Veränderung, bzw. Deindexierung, ist global zu beobachten. Sie gilt beispielsweise auch für guitaretab.com in den Vereinigten Staaten:

Die Deindexierung zig-tausender URLs scheint auf die Nische der Gitarren-Tab-Seiten beschränkt zu sein. Außerdem wurden die Positionen in den Suchergebnissen von Domains übernommen, die mehr oder weniger den gleichen Inhalt (Tabs für Gitarren) anbieten. Und der (ehemalige?) Marktführer Ultimate-Guitar rankt für einige Keywords weiterhin; jedoch mit unpassenderen Unterseiten und dementsprechend auf schlechteren Position. Denn nicht die komplette Domain wurde deindexiert! Während die Subdomain tabs.ultimate-guitar.com komplett deindexiert wurde, sind die redaktionellen Inhalte weiterhin im Google Index zu finden. All dies spricht dafür, dass es sich bei den Gitarren-Domains um eine manuelle Maßnahme von Google handelt, die nicht mit dem Core Update zusammenhängen muss.

Die Deindexierung zig-tausender URLs scheint auf die Nische der Gitarren-Tab-Seiten beschränkt zu sein. Außerdem wurden die Positionen in den Suchergebnissen von Domains übernommen, die mehr oder weniger den gleichen Inhalt (Tabs für Gitarren) anbieten. Und der (ehemalige?) Marktführer Ultimate-Guitar rankt für einige Keywords weiterhin; jedoch mit unpassenderen Unterseiten und dementsprechend auf schlechteren Position. Denn nicht die komplette Domain wurde deindexiert! Während die Subdomain tabs.ultimate-guitar.com komplett deindexiert wurde, sind die redaktionellen Inhalte weiterhin im Google Index zu finden. All dies spricht dafür, dass es sich bei den Gitarren-Domains um eine manuelle Maßnahme von Google handelt, die nicht mit dem Core Update zusammenhängen muss.

Weitere Veränderungen

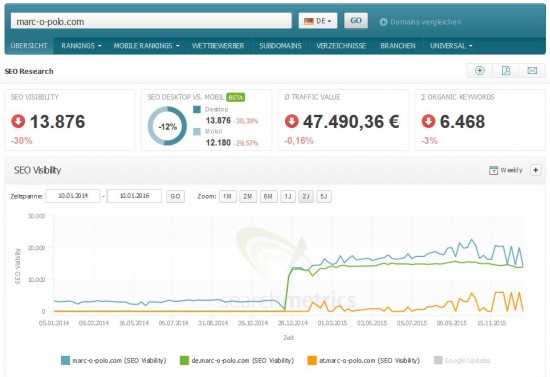

Nicht jede gravierende Veränderung in den Suchergebnissen von Google ist auf die Auswirkungen von Updates im Algorithmus zurückzuführen. Dies verdeutlicht etwa die Analyse der Website von Marc O’Polo, die mit einem Visibility-Minus von 30 Prozent zu den Hauptverlierern in Deutschland gehört. Jedoch zeigt die genauere Auswertung der Visibility-Kurve der Website für den deutschen Google-Index, dass die Schwankungen in der Sichtbarkeit einzig von der österreichischen Subdomain at.marc-o-polo.com stammen. Dagegen ist die Visibility der de-Subdomain recht stabil. Hier haben also URLs der österreichischen Subdomain in den Suchergebnissen für google.de gerankt.

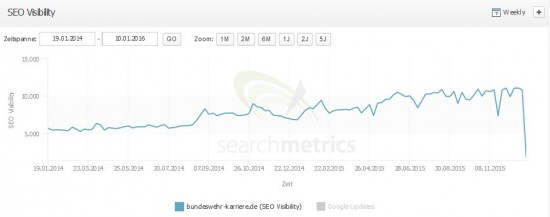

Eine weitere massive Veränderung, die nichts mit dem Update zu tun hat, zeigen die Daten aus der Suite für bundeswehr-karriere.de. Die Seite hat gegenüber der Vorwoche 83 Prozent Visibility verloren:

Grund dafür ist ein Relaunch der Website mit einer neuen Seitenstruktur – bei dem die alten URLs allesamt per Redirect auf die Startseite führen.

Wir beobachten die aktuellen Daten und werden euch zu den Auswirkungen des aktuellen Updates auf dem Laufenden halten. Habt ihr Beobachtungen oder Hinweise zum aktuellen Google-Update? Ich freue mich über eure Beiträge in den Kommentaren!