Als häufiger Nutzer von „Voice Search“ und bekennender Siri-Fan habe ich zum Release von Google Home auf Deutsch die drei Sprachassistenten von Apple, Microsoft und Google einem Praxistest unterzogen. Alle drei Systeme sind schon sehr überzeugend, haben aber noch Nachholbedarf. Klarer Gewinner im Praxistest: Google Home.

Im Searchmetrics-HQ bin ich dafür bekannt, sehr oft (und oft unnötig) mit meinem Handy zu sprechen. Ein einfaches „Hey Siri, brauche ich einen Regenschirm?“ wird von Kollegen mit einem – sicher gut gemeinten – „Schau doch aus dem Fenster.“ quittiert, während Siri noch brav die Antwort „Ich denke nicht, dass es regnen wird.“ runterplappert.

Ihr merkt, ich bin bekennender Siri-Fan. Als solcher interessierte es mich, Google Home zum Deutschlandstart auf die Probe zu stellen. Also zack – das Google Home im Büro eingesteckt und übers Wochenende getestet.

Und BOAH hat das Gerät mich überzeugt!

Versuchsaufbau – (Suchan-)Fragen mit entsprechendem Suchvolumen

Ich habe 100 Fragen mit monatlichem Suchvolumen zwischen 2.000 und 180.000 genutzt und an allen digitalen Assistenten in meinem Haushalt getestet. Untersucht wurden Google Home, Microsoft Cortana auf meinem Windows-Computer und Siri auf meinem iPhone.

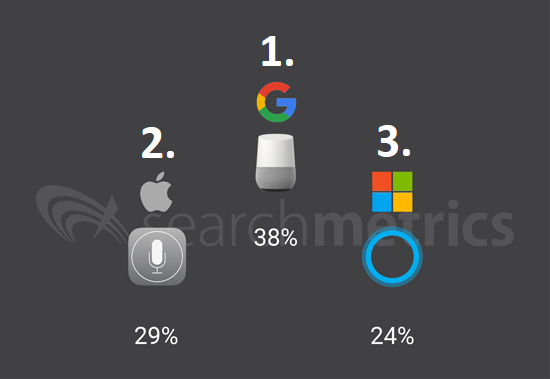

Das Gesamtergebnis im Überblick

Eindeutiger Sieger ist Google Home 38% korrekt beantworteten Fragen, gefolgt von Siri mit 29%. Das Schlusslicht bildet Cortana mit lediglich 24% korrekt beantworteten Fragen.

Ergebnisse im Detail – Einfluss von Suchintegrationen und Fragewörtern

Knowledge Graph

Spannend ist, dass bei Fragen, für die auf Google.de ein Knowledge Graph auf der rechten Seite der Suchergebnisse ausgespielt wird, alle Systeme überdurchschnittlich gut performt haben. Im Schnitt erfolgten hier zu 67% korrekte Antworten. Besonders deutlich konnte hier Google Home mit 80% richtig beantworteten Fragen herausstechen.

Direct Answer & Featured Snippet

Anders sah es bei Direct Answers und Featured Snippets aus. Während Google Home hier in 66% (also ein deutlich höherer Anteil als über alle Keywords) aller Fälle korrekte Antworten liefern konnte, hatten Cortana und Siri keine Leistungsteigerung. Hier profitiert Google Home also sehr deutlich davon, dass Google die mit großem Abstand beste Websuchmaschine im Hintergrund hat.

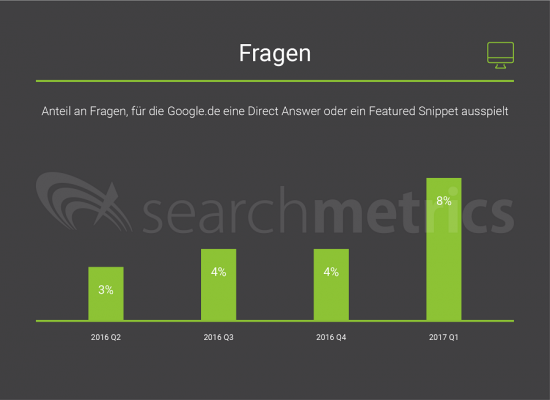

Da Google jedes Quartal zu mehr und mehr Fragen eine Direct Answer oder ein Featured Snippet ausspielt, ist davon auszugehen, dass sich Google Home im gleichen Maße verbessern wird.

In der untenstehenden Grafik stellt sich die Entwicklung der Einbindung von Direct Answers und Featured Snippets im Zeitraum eines Jahres, von Q2/2016 bis Q2/2017, für ein Keywordset von mehreren tausend Fragen dar.

In den USA beantwortet Google in den Suchergebnissen bereits deutlich mehr Fragen. Im gleichen Zeitraum ist der Anteil dort von 27% auf 29% gewachsen.

Wer mehr über das Thema und Optimierungsmöglichkeiten für Direct Answers wissen möchte, der kann sich gern in unserem Blogbeitrag: “Direct Answers bei Google: Wie ranke ich mit direkten Antworten?“ weiter informieren.

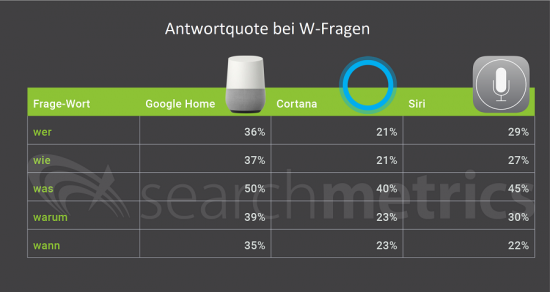

W-Fragen

Alle drei Systeme können „Was“-Fragen deutlich häufiger als alle anderen Fragen beantworten. Im Mittelwert wurden 45% aller „Was“-Fragen beantwortet, jedoch nur 28% aller Nicht-„Was“-Fragen.

Auch hier liegt Google Home bei allen W-Fragen prozentual vorn.

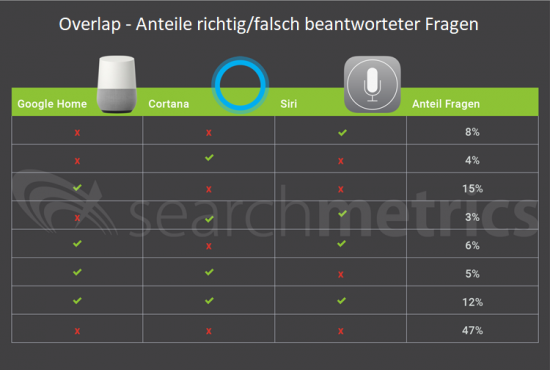

Overlap – richtig und falsch beantwortete Fragen

Alle drei Sprach-Assistenten sind an 47 Fragen gescheitert und konnten 12 Fragen korrekt beantworten. Bei den restlichen 41 Fragen lag Google Home am häufigsten richtig. Jedoch möchte ich nicht unerwähnt lassen, dass es 3 Fragen gab, die Cortana und Siri korrekt, Google Home aber falsch oder gar nicht beantwortet hat. Zusammen konnten Cortana und Siri insgesamt 15 Fragen beantworten, auf die Google Home keine Antwort wusste. Konkret sieht die Verteilung so aus:

Besonderheiten – Easter Eggs, Kontextsuchen und Probleme

Zitate von Websites

Nur Google Home hat von Websites zitiert und diese Zitate auch als solche kenntlich gemacht. Insgesamt hat Google bei 47% der korrekten Antworten eine Website zitiert.

Conversational Search

Google Home und Cortana haben jeweils 2-3 mal eine Interaktion gestartet. Also zum Beispiel bei der Frage „Wer hat heute Geburtstag?“ um Freigabe meines Kalenders gebeten oder auf die Frage „Was soll ich heute essen?“ angeboten, entweder Essen zu bestellen oder vorgeschlagen, Rezepte zu suchen. Bei Siri war dies bei keiner einzigen Frage der Fall.

Freche und “menschliche” Antworten

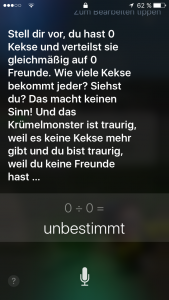

Bei dem Versuch, frech und menschlich zu wirken, geht Siri mit 7 Treffern in Führung. Allerdings waren die Antworten oft sehr plump, wie „Das ist eine interessante Frage“. Das nervt eher und ist nicht lustig. Als Positiv-Beispiel möchte ich die Suche nach „Was ist 0 geteilt durch 0?“ nennen:

Bing-Suchen

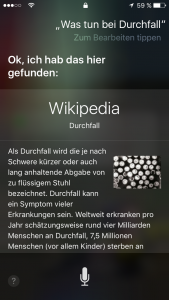

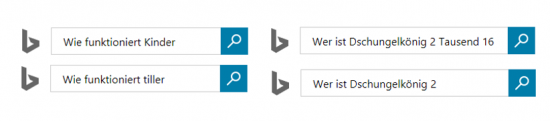

Ich glaube, ich habe noch nie so viele Bing-Suchen an einem Tag durchgeführt. Cortana hat 71 Bing-Suchen gestartet und konnte meine Frage damit bis auf eine einzige Ausnahme nie beantworten. Auch Siri hat 45 unnötige Bing-Suchen durchgeführt (für mich unnötig, weil es dort keine direkte Antwort gab. Eine Suche kann ich selbst durchführen und dann auf die Websites klicken und lesen).

Falsch verstanden

Cortana hat nur einmal die Intention einer Frage falsch verstanden. Google Home dreimal und etwa auf die Frage „Was ist Liebe?“ Musik abgespielt.

Siri hat meine Intention sogar ganze siebenmal falsch verstanden. Hier ein paar Beispiele:

Kurioses und Fun-Facts

Fasching vs Karneval

Google Home kennt die Antwort auf “Wann ist Fasching?” aber nicht auf “Wann ist Karneval?”

Google mit Sprachfehler

Mein Google Home war auf die Sprache Deutsch gestellt und hat Fragen, egal ob ich sie auf Deutsch oder Englisch gestellt habe, immer auf Deutsch beantwortet. Und plötzlich ist das hier passiert:

Auch wenn auf Facebook vermutet wurde, dass Google Home meinen Akzent imitiert hat, ist hier vermutlich einfach nur ein englischer Text fälschlicherweise als Deutsch klassifiziert worden.

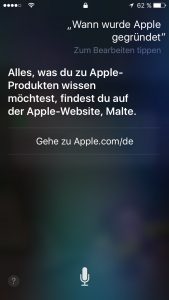

Siri und Apple

Geradezu lächerlich ist es, dass Siri selbst einfachste Fragen zu Apple nicht beantworten kann.

Fazit: Ich habe mir ein Google Home gekauft

Ich denke die Tatsache, dass ich bereits vor Ende des Test-Wochenendes mein eigenes Google Home bestellt habe, sagt alles.

Auch wenn man an meinen Tests – und auch an denen meiner Kollegen („Voice Search im SEO-Check: Liest Google Home immer das erste Suchergebnis vor?“ ) – sehen kann, dass es noch viel Entwicklungspotenzial gibt, habe ich sämtliche Bedenken bezüglich meiner Privatsphäre in dem Moment über Bord geworfen, als die Spotify-Verknüpfung und das Stellen von Timern (etwa beim Kochen) funktioniert haben.