Content soll aus der Masse von Online-Inhalten herausstechen und Usern einen echten Mehrwert liefern – darüber sind sich Marketer einig. Stimmen die technischen Voraussetzungen jedoch nicht, um eurem Content eine Bühne für einen wirkungsvollen Auftritt zu geben, verfliegen die investierten Bemühungen schnell. Im Webinar haben sich unsere Experten diesem Thema angenommen und zeigen, auf welche technischen Faktoren ihr unbedingt achten solltet, um euren Content nachhaltig erfolgreich zu machen.

Lesetipp: Im Whitepaper “Content der Performt” zeigt Searchmetrics gemeinsam mit den Content-Marketing- und Content-Seeding-Experten von suxeedo wie ihr Inhalte entwickelt, die garantiert Traffic erzeugen und konkret auf die Bedürfnisse der User eingehen.

Ihr investiert viele Stunden in die Erstellung neuer Inhalte, um für euer Unternehmen online mehr Reichweite zu gewinnen. Die anschließenden Analysen zeigen dann jedoch: Die so mühsam entwickelten Inhalte performen nicht wie gewünscht – die technischen Grundlagen fehlen. Was könnt ihr tun? Im Webinar “Welche technischen Faktoren verhindern den Erfolg Ihres Contents?” nehmen sich unsere Experten Niels Dahnke, Head of SEO bei suxeedo, und Marcus Pentzek, Chief SEO Consultant bei Searchmetrics, dieses Problems an und helfen euch die Hürden technischer Faktoren zu überwinden.

Diese Themen wurden im Webinar besprochen:

- Was verhindert den Erfolg eures Contents?

- Welchen Tools könnt ihr schnell und einfach mögliche Probleme identifizieren?

- Wie beseitigt ihr diese Hürden selbst?

Unsere Experten:

|

Niels Dahnke Head of SEO |

Chief SEO Consultant |

Ihr habt das Webinar verpasst? Hier könnt ihr euch die Aufzeichnung ansehen:

Fragen und Antworten zum Webinar

Hier beantworten unsere Experten Nils und Marcus einige Fragen unserer Webinar-Teilnehmer. Sind eure Fragen nicht dabei? Dann hinterlasst uns einen Kommentar und sagt uns, was ihr wissen möchtet.

Wie sollten Parameter-URLs, der Canonical und ggf. der hreflang ausgezeichnet werden? Referenzieren sie jeweils auf die originale URL ohne Parameter und die entsprechenden Sprachversionen?

Marcus, Searchmetrics:

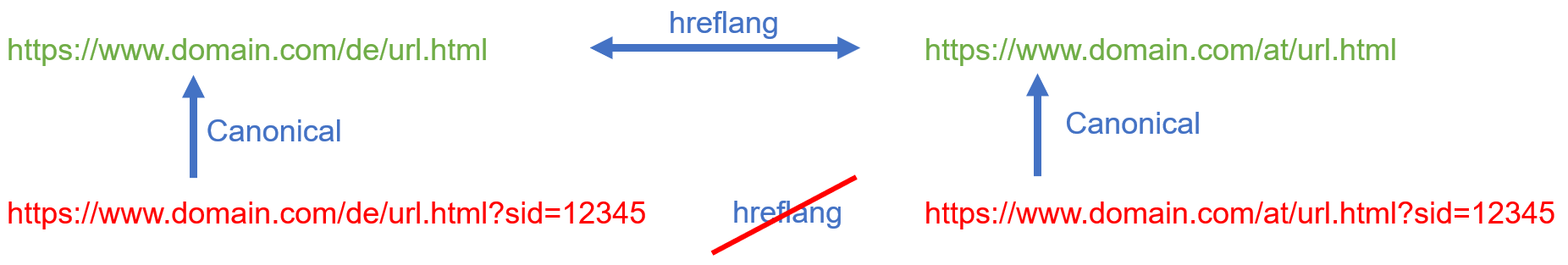

Hreflang und Canonicals sind ein Thema, das immer wieder falsch gemacht wird, obwohl es doch so einfach ist (hier spricht der Nerd aus mir). Grundsätzlich werden in Canonical als auch in hreflang nur URLs referenziert, die auch indexiert werden sollen. Parameter-URLs sind häufig nur Kopien der URLs ohne Parameter und haben daher nichts im Google-Index verloren. Sie sind also weder Ziel des Canonicals, noch von hreflang. Dies gilt für URL-Parameter, die für den Inhalt der Seite nicht wirklich von Bedeutung sind, wie Session-IDs, Tracking-Parameter, etc.

Habt ihr nun eine solche Parameter-URL, verweist ihr mit dem Canonical auf die Variante ohne Parameter. Die aktuelle Parameter-URL mag auch in anderen Sprachen oder für andere Länder vorliegen. Da sie aber nicht indexiert werden soll, wird sie auch nicht mit hreflang behandelt. Der einfache Grund dahinter ist, dass die Ziel-URLs der hreflang-Tags auf diese URL zurückverweisen müssten – was sie nicht tun, da es sich um eine nicht zu indexierende URL handelt.

Klingt wirr – daher versuche ich es über ein kleines Schaubild einfacher zu erläutern:

Niels, suxeedo:

Wichtig ist bei Parameter-URLs erst einmal, dass man insbesondere bei mehreren hintereinander gesetzten Parametern eine einheitliche Reihenfolge und Schreibweise definiert. Auch eine veränderte Reihenfolge der Parameter oder geringe Abweichungen bei den Parameter-Namen (z.B. ProductID ist nicht identisch mit productid), kann Duplicate Content erzeugen. Was ebenfalls gerne falsch gemacht wird, ist die Erzeugung von Paginierungen über Parameter-URLs, wobei die kanonische URL bei allen Unterseiten auf die erste Seite zeigt. Da die einzelnen Folgeseiten jedoch unterschiedliche Inhalte haben, führt das eher dazu, dass Google die kanonischen URLs einer Domain ignoriert. Passiert das, verliert man ein sehr mächtiges Werkzeug zur Steuerung des Crawlers.

Mit welchem Tool wurde die interne Verlinkung visualisiert?

Niels, suxeedo:

Die Visualisierung wurde mit Gephi umgesetzt. Es gibt mittlerweile mehrere Anbieter die ähnliche Visualisierungen anbieten, die umfangreichsten Filter- und Visualisierungsmöglichkeiten gibt es jedoch in Gephi. Als Datenbasis wurde der csv-Export eines Crawls mit Screaming Frog SEO Spider genutzt. Grundsätzlich lassen sich csv-Exporte anderer Crawler sicher ebenfalls verwenden.

Bei anderen Tools, die solche Analysen automatisch anbieten, sollte man sich genau anschauen, ob diese wirklich hilfreich sind. Die Grafiken sehen hübsch aus aber ob sich daraus wirklich Empfehlungen ableiten lassen, ist mehr als fraglich. Daher muss man immer schauen, was das Ziel ist und ob die Darstellung hilfreich ist. Bei Gephi kann ich viel selbst beeinflussen, filtern, einfärben und anderweitig die Visualisierung anpassen, sodass sich der Mehraufwand lohnt.

Sollte man bei einem kompletten Website Relaunch alte Blog-Beiträge (Alter: 3-4% 2 Jahre) übernehmen.

Niels, Suxeedo:

Im Rahmen eines Relaunch aufzuräumen – das kann man schon machen. Das Alter eines Blog-Beitrags ist jedoch kein hilfreiches Entscheidungskriterium. Externe Verlinkungen und Traffic auf den Beitrag, sind hingegen sehr wichtige Faktoren. Hier kann gerade ein alter Artikel sehr bedeutend und relevant sein. Würde man so einen Beitrag löschen, ist das eher negativ und kann einen nachhaltigen Schaden erzeugen. Auch die Betrachtung des elementaren Inhalts als thematische Autorität kann eine Rolle spielen. Ist der Blog-Beitrag für eine holistische Abdeckung des Themenumfelds wichtig, so sollte der Inhalt erhalten bleiben. Ähnlich ist es bei Inhalten, die Aufgrund von saisonalen Effekten oder in periodisch größeren Zeiträumen auftauchen. Es finden beispielsweise alle 4 Jahre die Olympischen Spiele statt. Wenn dadurch ein Inhalt alle 4 Jahre wieder aktuell wird, wäre eine Löschung von passenden Inhalten, die schon 2 Jahre alt sind, nicht sinnvoll. Ähnliche Muster gibt es für viele Themen. Daher ist eine generelle Aussage auf Basis des Alters von Inhalten nicht sinnvoll.

Ist ein alter Inhalt eigentlich sinnvoll, hilfreich oder wichtig, bekommt aber keinen Traffic oder ist im Ranking erst in den Suchergebnissen bei Google auf Seite 3 oder schlechter auffindbar, kann eine Erweiterung des Artikels ebenfalls eine gute Lösung sein. Der Blog-Beitrag hat vielleicht aufgrund des Alters bereits eine gewisse Reputation erlangt. Das sollte man nutzen. Durch ein Update des Blog-Beitrags kann Google gezeigt werden, dass der Inhalt weiterhin relevant ist. Dieses Vorgehen wird bei vielen redaktionellen Websites als Republishing aktiv betrieben.

Marcus, Searchmetrics:

Diese Frage lässt sich nicht beantworten, ohne jeden einzelnen Blog-Beitrag gesichtet zu haben. Zunächst einmal kann es aus SEO-Perspektive sein, dass ältere Beiträge Rankings haben, die man unbedingt behalten möchte. Diese Beiträge würde man nicht löschen. Ob sie behalten, geupdatet, in einen anderen Artikel übertragen und weitergeleitet werden sollen, wäre dann eine andere Entscheidung.

Artikel, die weder Rankings, noch Impressions und Clicks (Google Search Console) haben, können theoretisch gelöscht werden – welchen Wert haben sie denn noch? Ganz im Gegenteil, denn trotz des Fehlens von Rankings und organischem Traffic, können diese Beiträge wertvoll für eure Website und Thematik sein. Es geht nicht immer nur um SEO, wenn man über den Content urteilen muss: Sind ältere Blog-Beiträge potentiell wertvoll für eure Besucher? Habt ihr keinen neueren oder besseren Content zu denselben Themen? Dann solltet ihr ihn vielleicht dennoch behalten. Hier geht es dann darum, die Qualität aufzuwerten und aus diesen veralteten Beiträgen wertvolle Inhalte zu gestalten, die vielleicht dann doch (wieder) die Chance auf neue Rankings und Besucher haben.

Ich kenne es aus meinen alten Blogs, dass ich immer wieder recht kurze Dinge veröffentlicht habe, nur um in dieser Woche wieder etwas geschrieben zu haben. Diese Artikel vermissen oft Qualität, ein klares, zeitloses Thema, usw. – solche Beiträge kann man getrost löschen.

Wenn Inhalte zu Recht gelöscht werden, solltet ihr wieder die SEO-Brille aufsetzen und schauen, ob es nicht externe Verlinkungen gibt, die ihr retten möchtet. Vielleicht findet sich ja ein besserer Artikel zu dem Thema, der im Blog bleiben wird, um die alte URL darauf weiterzuleiten.

Ist auch der Text von internen Links relevant? Sollte ich möglichst meinen Firmen-Markennamen mit verlinken oder reicht beispielsweise nur das Produkt aus, wenn es sich um eine eigenständige starke Marke wie ‘Microsoft Office 2019’ handelt?

Marcus, Searchmetrics:

Der Text, über den verlinkt wird, ist der sogenannte Linktext oder auch Anchor-Text. Dieser ist, insbesondere in der internen Verlinkung, ein wichtiges Merkmal für Google, um Rückschlüsse auf die wichtigsten Inhalte der Zielseite zu ziehen. Natürlich wird Google jede einzelne Seite inhaltlich im Detail betrachten, dort Title Tag, Headlines und Content einsehen und diese interpretieren, um zu bewerten, wofür diese Seite denn grundlegend ranken sollte. Zusätzlich wertet Google die Linktexte aller internen Links, die auf jede einzelne Seite verweisen, aus. Die Suchmaschine will so eure Intention als Webmaster für die Relevanz diese Seite verstehen. Deckt sich diese Information mit dem was Google über andere Wege ermittelt hat, stärkt dies das Signal für diese Keywords zu ranken.

Euer eigener Firmenname (sagen wir mal “Saturn”, wenn ihr Webmaster / SEO von Saturn.de wärt) hat mit dem Inhalt der Produktseite zu “Microsoft Office 2019” oft nicht viel zu tun. Der Firmenname / eure Brand ist “lediglich” die Plattform auf der dieses Produkt angeboten wird. Es genügt also völlig, wenn ihr einen für den Nutzer sinnvollen Linktext verwendest.

Der Link zur Startseite deiner Website dagegen, kann durchaus deinen Firmennamen vertragen – denn deine Startseite ist das virtuelle Schaufenster deiner Firma – es geht also um deine Firma.

Niels, suxeedo:

Ist der Firmen- oder Markenname relevant? Wird aktiv in dieser Kombination danach gesucht? Ist euer Firmenname wirklich wichtig oder seid ihr aus Sicht des Kunden erst einmal nur ein Lieferant? Insbesondere bei der Suche nach ‘Microsoft Office 2019’ wird einem Nutzer erst einmal egal sein, wer das Produkt verkauft oder Fragen zum Produkt beantworten kann. Ist eure Domain selbst bereits eine starke Marke, ist es nicht erforderlich den Firmen-Markennamen auf eine Produktseite mit zu verlinken.

Geeignet kann dieses Vorgehen jedoch dann sein, wenn Ihr ein Alleinstellungsmerkmal habt oder wenn ihr euch als Marke positionieren wollt. Geht es also nicht nur um das Produkt, sondern um euch z.B. als Schulungsanbieter, dann kann es sinnvoll sein. In so einem Fall geht es nicht nur um ‘Microsoft Office 2019’, sondern um Schulungen. Dann seid ihr als Schulungsanbieter selbst das Produkt und solltet euch als Marke mit in den Link aufnehmen. Wir können zur Stärkung der Marke für uns als Agentur also ‘suxeedo Seeding-Whitepaper’ und nicht nur ‘Seeding-Whitepaper’ als Linktext verwenden.

Bringt der HTML5 Tag “main” Google etwas?

Niels, suxeedo:

Meine Empfehlung ist “mach es Google so leicht wie möglich, die relevanten Inhalte zu finden”. Zudem geht es im Zweifel immer darum, ob es bei der Bewertung einer Seite positive Relevanzmerkmale gibt, die euch einen Vorteil verschaffen können. Ich hatte einen Kunden, der plötzlich für “BMW” gefunden wurde und auch Traffic bekommen hat. Die Absprungrate war bei 100% für diesen Inhalt und die Verweilzeit unter 3 Sekunden. Was war passiert? Es war eine Seite mit viel Text in dem es um Fahrzeuge ging. Aber es ging nicht um BMW, sondern um die Modelle eines anderen Autobauers. Innerhalb der Seite wurde Textwerbung angezeigt, die offenbar massiv von dem bayerischen Autobauer gebucht worden war. Da Google die Textwerbung als solche nicht erkannt hat, war der Seite fälschlicherweise eine inhaltliche Relevanz für dieses Thema zugeordnet. Wir haben das Problem gelöst, indem das HTML für die Auszeichnung der Intext-Werbung verändert wurde. Hier zeigt es sich, dass die korrekte Verwendung von Tags zur Strukturierung von Inhalten für Google elementar sein kann. Es ist jedoch nicht so, dass lediglich durch das Hinzufügen des Tags “main” ein riesiger Vorsprung erreicht und dadurch sofort ein verbessertes Ranking erzielt wird.

Marcus, Searchmetrics:

Ob der Einsatz <main> einen Ranking-Vorteil bietet, denke ich eher nicht. Dennoch kann der Einsatz aller semantischen Tags in HTML5 Google dabei helfen, eure Seite besser zu verstehen. Google’s Analyse-Algorithmen sind zwar durchaus in der Lage zu erkennen, wo der Kopfbereich deines Layouts, die Navigation, der Footer und der Main-Bereich ist oder auch welches die wichtigsten Überschriften sind – selbst wenn diese in falscher Hierarchie oder sogar ohne Heading Tags ausgezeichnet wurden. Aber diese Algorithmen sind nicht unfehlbar und erfordern viel Interpretations-Arbeit von Google. Wenn ihr mit dem korrekten Einsatz von semantischen Tags – und dazu zählt auch <main> – die Arbeit von Google erleichtert, kann dies dazu führen, dass Google eure Seite besser versteht und die richtigen Inhalte bewertet.

Welches Team muss die technischen Faktoren evtl. korrigieren?

Niels, suxeedo:

In den meisten Fällen werden sich Techniker bzw. Entwickler darum kümmern müssen. Aber auch diese Frage lässt sich nicht ganz so leicht beantworten. Es kommt darauf an, was genau zu korrigieren ist.

Eine fehlerhafte Verwendung des Editors im Backend des CMS wird der Anwender, also z. B. der Redakteur, selbst korrigieren müssen. Falls das Marketing direkten Zugriff auf den Google Tag Manager hat, können darüber Fehler eingebaut worden sein, die zwar ein Techniker bzw. ein Entwickler beheben kann. Es muss jedoch dafür gesorgt werden, dass sich derartige Fehler nicht erneut einschleichen. Sollte das UX-Team für die Verwendung der Web Fonts verantwortlich sein, muss sich dieses Team um eine Korrektur kümmern.

Genau hier zeigt sich sehr schön, dass SEO ein Prozess ist, der viele Bereiche im Unternehmen betreffen kann. Im Zweifel kann es hilfreich sein, sich externe Unterstützung durch eine SEO-Agentur zu suchen. Dann lässt sich schnell eingrenzen, welche technischen Faktoren korrigiert werden sollten und in wessen Zuständigkeit dies fällt. Wir werden von suxeedo regelmäßig für SEO Audits gebucht und kommen wie ein technische Sachverständiger zur Prüfung hinzu. So ähnlich, wie es beim PKW der Fall ist, wo der TÜV die Prüfung macht, aber die Werkstatt die Fehler behebt.

Warum verschlechtern Web Fonts die Ladegeschwindigkeit?

Niels, suxeedo:

Das hat gleich mehrere Ursachen. Zum einen steigt die Zahl der Verbindungen zwischen Browser und Web Server. Je nach Konfiguration, verwendetem HTTP-Protokoll und Art der Einbindung müssen mehrfach Verbindungen hergestellt werden. Danach werden die Daten übertragen und anschließend wird die Verbindung wieder geschlossen. Im Anschluss erfolgt im Browser eine Veränderung der Darstellung (Rendering). Manche Elemente können die Darstellung im Browser blockieren. Nutzer sehen die Inhalte der Webseite also erst, wenn die Web Fonts geladen wurden, obwohl der eigentliche Inhalt wesentlich früher angezeigt werden könnte.

Hinzu kommt, dass Designer und Entwickler sich die Arbeit gerne leicht machen. Wenn also für ein einzelnes Icon ein kompletter Web Font mit vielen Zeichen geladen wird, dann ist es für den Entwickler schnell erledigt und erzeugt intern erst einmal geringe Kosten. Bei den Anwendern kann dies jedoch zu einer schlechteren Ladezeit führen und kostet damit die Zeit des Crawlers, der Kunden und Mitarbeiter. In einer Gesamtbetrachtung kann es daher wesentlich günstiger sein, wenn man nicht nur auf die Zeit für die Implementierung durch die Entwickler schaut, sondern das Ziel der Geschwindigkeitsoptimierung im Blick behält. Wenn ihr dann nur einen Web Font nachladet und nicht sieben oder mehr, beeinflusst das die Ladegeschwindigkeit sehr deutlich. Bei Kunden sehen wir immer wieder, dass eben nicht nur eine einzige Schrift, sondern mehrere verwendet werden. Web Fonts verschlechtern also sowohl beim Ladeverhalten, als auch beim Rendering und der Darstellung der Inhalte die Ladegeschwindigkeit negativ.

Marcus, Searchmetrics:

Dem ist nichts mehr hinzuzufügen ;-)

Wie kann man die Website Usage von fremden Websites prüfen?

Marcus, Searchmetrics:

SimilarWeb z. B. hat ein großes Panel an vielen verschiedenen Browser Plugins, die Menschen rund um den Globus nutzen, um verschiedene Erleichterungen beim Surfen zu nutzen. Diese Plugins liefern im Gegenzug SimilarWeb Informationen darüber, über welche Kanäle Besucher auf die verschiedenen Websites kommen – aber eben auch, wie viel Zeit sie (im Durchschnitt) auf einer Website verbringen und mit welcher Wahrscheinlichkeit sie bouncen. Je größer die Website, desto zuverlässiger sind die Daten – auch bereits in der kostenlosen Version.

Niels, suxeedo:

Neben SimilarWeb würde ich in Verbindung mit ‘Website Usage’ noch einen Blick auf die Daten aus dem Chrome User Experience Report (CrUX) werfen. Hier werden insbesondere detaillierte Daten über die verwendeten Endgeräte bei der Nutzung der Websites sichtbar.

Als Selbständiger, der sich eine Website aus einem Baukasten-System erstellen wird: Gibt es bei solchen Systemen im Hinblick auf die genannten 17 Faktoren etwas Besonderes zu beachten oder gelten die Hinweise aus dem Webinar uneingeschränkt auch hier?

Niels, suxeedo:

Viele Baukasten-Websites lassen eine Beeinflussung der genannten 17 Faktoren nur für wenige oder eventuell keine der Punkte zu. Insbesondere wenn sich Seitentitel und Meta Description nicht sinnvoll beeinflussen lassen, würde ich von einer Nutzung abraten. Die Vorlagen solcher Baukästen versprechen zwar einen schnellen Erfolg bei der Umsetzung, wenn sich am Ende der Erfolg jedoch nicht einstellt, dann war die Entscheidung für so einen Baukasten aus unternehmerischer Sicht eine Fehlentscheidung. Die Frage sollte daher sein, was erreicht werden soll. Will ich eine Landingpage für eine SEA-Kampagne erstellen, dann kann so ein Baukasten genau richtig sein. In einem Umfeld mit Wettbewerbern gewinnt im Zweifel derjenige, der die bessere Website hat. Und das bezieht sich sowohl auf die Inhalte, als auch auf die Technik und das Linkprofil. Selbst wenn man im Baukasten ein “SEO-Paket” dazubuchen kann, so verdient es sich in den wenigsten Fällen diesen Namen. Achtet daher bei der Entscheidung für oder gegen ein Baukasten-System auf eure Ziele und nutzt die genannten 17 Punkte ruhig wie eine Checkliste. Welche der genannten Punkte kann der Baukasten bieten?

Marcus, Searchmetrics:

Google ist es gewohnt mit nicht perfekten Websites umzugehen, die dennoch spannende Inhalte bieten. Daher ist es durchaus möglich, auch mit Baukastensystemen, die nicht bis ins letzte Detail optimierbar sind, gute Rankings zu erreichen. Genauso wie viele WordPress Websites, die mit schlechten Templates umgesetzt wurden oder ohne SEO Plugin gute Rankings erzielen. Es geht in die Richtung, die Niels bereits in der Beantwortung der Frage nach HTML5 erwähnt hat: Man sollte es Google so einfach wie möglich machen. Daher ist die Idee, die in Frage kommenden Systeme zunächst auf Basis der Checkliste zu bewerten und am Ende das kleinste Übel zu wählen, sicher der bessere Weg, als auf eine Website zu verzichten.

Gibt es vermeidbare Probleme bei der Cookie-Auswahl?

Niels, suxeedo:

Betrachten wir erst einmal die technische Seite dieser Frage. Das Setzen und Abfragen von Cookies braucht Zeit und basiert auf Datenverbindungen, die Traffic erzeugen. Hier sollte man sich die Frage stellen, ob HTTP-Cookies grundsätzlich immer sinnvoll und erforderlich sind. Insbesondere für die Auslieferung statischer Daten (z.B. Bilder, JavaScript, CSS) ist es ratsam, diese über eine sogenannte Cookieless Domain ausliefern zu lassen, um unnötigen Datenverkehr zu verhindern und damit die Ladegeschwindigkeit zu verbessern. Typischerweise werden solche statischen Inhalte daher per CDN (Content Delivery Network) ausgeliefert. Viele CDN-Anbieter stellen Domains oder Subdomains zur Verfügung, die selbst keine Cookies setzen. Derartige Cookieless Domains liefern die Daten daher schneller aus. Manche CDN-Anbieter liefern aus Sicherheitsgründen jedoch bewusst Cookies aus. Hier sollte im Vorfeld geklärt werden, wie ein CDN genau arbeitet und ein passender Anbieter ausgewählt werden.

Zur Beurteilung des Erfolgs einer Website und deren Inhalte empfehle ich zumindest in bestimmten Intervallen einen Abgleich der Tracking-Daten mit den Server Logfiles vorzunehmen. Werden Cookies blockiert und existiert kein Cookieless Tracking, gehen ansonsten eventuell wertvolle Informationen verloren. Insbesondere Informationen über das Crawling-Verhalten von Suchmaschinen, lassen sich aus Server Logfiles wesentlich besser auslesen, als dies über andere Tracking-Anwendungen gewöhnlich der Fall ist. Derartige Informationen können für das interne Linkbuilding oder für die Weiterentwicklung vorhandener Inhalte elementar sein.

Eine Rechtsberatung kann und darf ich zu dieser Frage nicht abgeben, trotzdem will ich darauf kurz eingehen. Grundsätzlich muss man bei Cookies natürlich auf die rechtlichen Rahmenbedingungen (z. B. DSGVO) achten. Die Verwendung von Drittanbieter-Cookies (sogenannten Third Party Cookies) würde ich persönlich immer vermeiden, soweit dies möglich bzw. sinnvoll ist. Die Web Browser Mozilla Firefox und Apple Safari haben Anti-Tracking-Methoden bereits seit längerem integriert und ab 2022 sollen Chrome Browser Third Party Cookies ebenfalls blockieren. Daher ist es bereits heute sinnvoll, die Verwendung derartiger Cookies zu vermeiden.

Was macht man, wenn eine unbekannte Person die Website auf einem Traffic Bot einstellt. Wie gefährlich ist das für SEO?

Niels, suxeedo:

Ein Traffic Bot kann je nach Art des Bots verschiedene Probleme erzeugen. Manche Bots erzeugen Traffic oder Scrapen die Inhalte der Website. Beim Scrapen der Inhalte kann dies zum Beispiel gewünscht sein, wenn z. B. Stellenausschreibungen oder ähnliche Inhalte dadurch auf anderen Websites wie Jobbörsen mit einer höheren Reichweite einen Mehrwert für das eigene Unternehmen bieten. Erzeugt der Bot jedoch ausschließlich Last auf dem eigenen Server, so kann dies sowohl zu höheren Kosten, als auch zu einer Verringerung der Servergeschwindigkeit führen. Bots, die für eine negative Performance des eigenen Web Servers verantwortlich sind, lassen sich zum Beispiel über die Konfiguration des Web Server oder einer Web Application Firewall sperren. Insbesondere wenn Inhalte gespraped werden, um diese für wettbewerbsverzerrende oder sogar illegale Maßnahmen zu verwenden, ist ein sperren solcher Bots eine wichtige Maßnahme.

Handelt es sich um einen Bot, der nicht nur gewöhnlichen HTTP-Traffic erzeugt, sondern eventuell Port Scans durchführt, ist hier ebenfalls von einem Bot auszugehen, der als problematisch einzustufen ist. Derartige Scans werden primär ausgeführt, um Schwachstellen auf Servern zu finden und diese zum Beispiel für Angriffe auszunutzen.

Zudem gibt es Traffic Bots, die gezielt versuchen Nutzersignale zu simulieren und dadurch positive oder negative Auswirkungen haben können. Wer dazu mehr erfahren will, kann sich gerne das entsprechende Whitepaper von der suxeedo-Website herunterladen. Nutzt hier ein Wettbewerber einen Traffic Bot zur Manipulation von Nutzersignalen, ist so etwas wesentlich schwerer zu verhindern, weil der Traffic gewöhnlich über die Google Suche kommt und damit ein Blockieren eines solchen Bots nur bedingt hilfreich ist.

Bevor ihr jedoch eine Sperre gegen einen Bot verhängt, sollte sichergestellt werden, dass Suchmaschinen nicht von derartigen Sperren betroffen sind. Eine fehlerhafte Sperre kann sich in negativen Nutzersignalen zeigen, die zu einem schlechteren Ranking in den Suchergebnissen bei Google führen.

Auch hier sieht man, wie sehr technische Faktoren den Erfolg des Contents beeinflussen können.

Marcus, Searchmetrics:

Niels war schneller in der Beantwortung und ich schließe mich seiner sehr ausführlichen Antwort uneingeschränkt an.

Eurem Content Marketing fehlt noch der letzte Schliff? Unsere Experten der Digital Strategies Group helfen gerne weiter. Vereinbart einfach einen Termin!

Marcus Pentzek

Marcus Pentzek