In der Artikelserie “Big Data in SEO” führe ich durch die sieben Themen, die für Enterprise-SEOs wichtig sind. In diesem Teil geht es um die technische OnPage-Optimierung und das Targeting.

Seit Ende 2011 ist die technische SEO Performance einer Website ein echter Ranking-Faktor. Und dabei geht es nicht nur um die Schnelligkeit. Es geht darum, möglichst wenige Fehler zu machen. Bei großen Sites hilft der Searchmetrics Crawler mit Big Data die technischen Probleme einer Website aufzudecken.

Im Grunde genommen ist die Technik einer Website nur dafür da, dem Google-Robot nicht im Wege zu stehen. Er soll jede URL möglichst schnell lesen und bewerten können. Doch das ist gar nicht so einfach ‒ vor allem, wenn es um große Webseiten geht. Es gibt zwei Bereiche, die bei der OnPage-Optimierung schnell unübersichtlich werden:

- Site Optimierung: (Fast) jede Webseite hat technische Probleme. Es wird auf Seiten verlinkt, die es nicht mehr gibt, Canonical Tags zeigen auf ein falsches Ziel oder der Aufbau der HTML-Dokumente ist unübersichtlich. Das ‒ und noch viel mehr ‒ prüft unsere “Site Optimization”. Hierbei analysiert unser Crawler bis zu 100.000 Unterseiten nach möglichen Fehlern, Warnungen und Hinweisen.

- Keyword Targeting: Damit das Dokument “XY” für ein Keyword gut ranken kann, muss es dem Google Robot zeigen, was es drauf hat. Für welches Keyword es die höchste Relevanz hat und ob die interne Verlinkung auch darauf fokussiert. Dies analysiert unser Crawler für jedes hinterlegte Keyword und die dafür rankende Seite.

Site Optimization

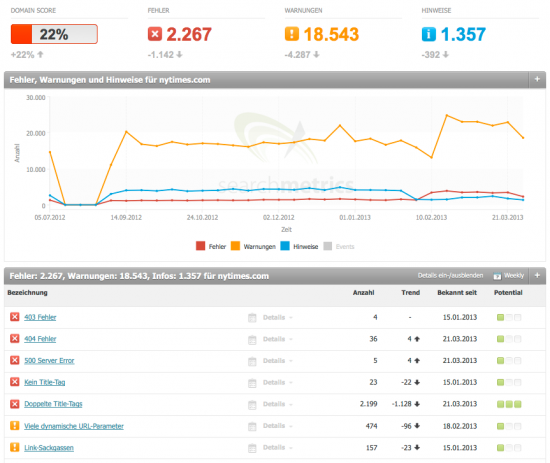

Selbst die Techniker der New York Times machen Fehler. Und zwar sogar eine ganze Menge. Zu erkennen ist das in der Searchmetrics Site Optimization:

Deutlich zu erkennen sind hier die Summe aller Fehler, Warnungen und Hinweise ‒ um die sich wohl ein Entwickler kümmern sollte. In dem Graph lässt sich auch der zeitliche Verlauf dieser Hinweise erkennen. Die Weiterentwicklung des Projektes kann hier also zweifelsfrei nachvollzogen werden.

Diese Daten sind die Grundlage unseres Crawlers, der sich durch jede eingegebene Projekt-Domain arbeitet und alles notiert, was notierenswert ist. Wir prüfen hierfür etwa 50 Faktoren, die für die OnPage-Optimierung einer Seite eine Rolle spielen. Mit dabei sind tote Links und andere Server-Fehler. Doch natürlich wird auch geprüft, ob die Meta-Angaben der Dokumente (Title-Tag, Description, Robots-Metatag usw.) korrekt ausgefüllt sind und ob die Dokumentenstruktur über die entsprechende Headline-Formatierung ablesbar ist. Außerdem gibt es noch zahlreiche weitere Faktoren, die für SEO wichtig sind. So weisen wir den Webmaster darauf hin, wenn es zu viele ausgehende Links auf einer Seite gibt oder die URL zu lang ist.

All diese Fehler prüfen wir einmal wöchentlich und stellen diese in der Übersicht dar. Und zwar mit einer Priorisierung hinsichtlich des Optimierungs-Potentials (rechte Spalte in der Tabelle) und mit dem Verlauf ‒ also der Veränderung zur Vorwoche.

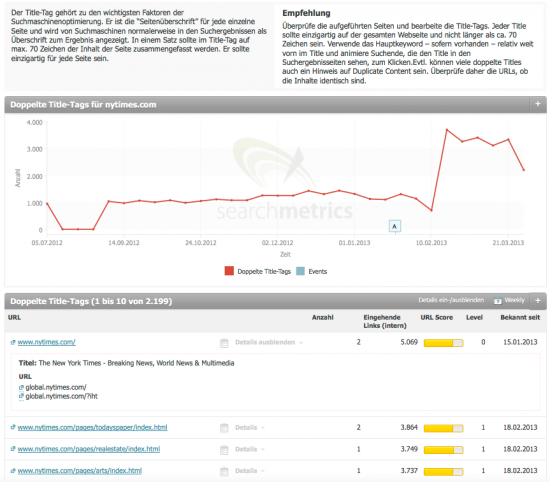

Für den einzelnen Fehler oder Hinweis gibt es auf der Detail-Seite, neben der Erklärung dazu und dem Verlauf, auch die notwendigen Detail-Daten:

Wenn wir also etwa doppelte Description-Tags finden, erklären wir oben, warum das ein Problem sein könnte und was zu tun ist. Übrigens: Auch doppelte Title-Tags sind ein mögliches Signal dafür, dass Inhalte mehrfach publiziert wurden, die Seite also durch Duplicate Content bedroht ist.

Der Verlauf der New York Times hier zeigt, dass sich Anfang Februar die Zahl der doppelten Description-Tags sprunghaft vermehrt hat. Hier wäre es wichtig, den Anlass dafür zu entdecken, um das Übel bei der Wurzel zu packen.

Weiter unten gibt es eine Liste aller doppelten Title-Tags mit den Detail-Informationen. Aufgeklappt ist hier der Fehler der Startseite zu sehen, welcher unbedingt gelöst werden sollte. Denn diese Seite hat mit 5069 eingehenden (internen) Links natürlich eine extrem hohe Relevanz. Ebenso ist natürlich das Level der Seite ein Signal für die Dringlichkeit der Fehlerbehebung.

Tipp: Kontinuierliche Arbeit an den Fehlern

Es ist vermutlich unmöglich, eine Website ganz ohne Fehler zu betreiben. Allerdings ist deren Reduzierung nicht nur für SEO wichtig, sondern wird auch den Besuchern der Seite zugutekommen. Deshalb empfehle ich, wöchentliche Techniker-Kapazitäten für die Behebung dieser Hinweise zu reservieren.

Keyword Optimization

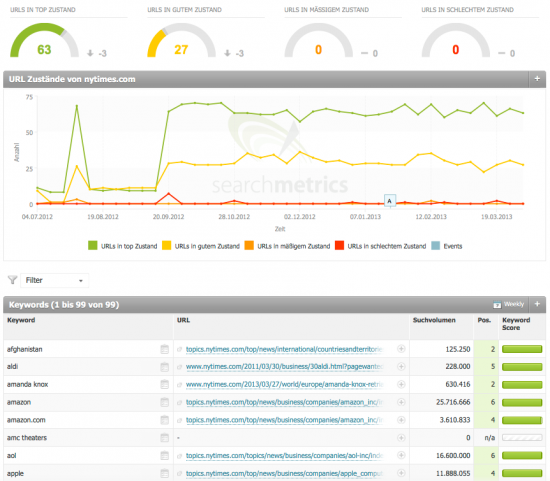

Eine andere Perspektive nimmt die Keyword Optimization ein: Hier überprüft unser Crawler, ob eine URL auch wirklich optimal zu dem Keyword passt, für das sie gefunden wird. Hierzu beobachten wir alle URLs, die schon für eines der hinterlegten Keywords im Google-Index ranken. Und wir bewerten sie danach, ob sie gut passen ‒ oder nicht:

Hier sieht die Bilanz der New York Times recht gut aus: Es gibt 63 URLs in einem Top-Zustand, an dem (fast) nichts mehr verbessert werden kann. Und es gibt 27 URLs in gutem Zustand, also mit Verbesserungspotential. Darunter finden wir auch hier den Verlauf und eine Tabelle mit all den hinterlegten Keywords. In dieser Tabelle sorgt das Suchvolumen und die Positionierung für eine ordentliche Einteilung in “wichtig” und “nicht wichtig”.

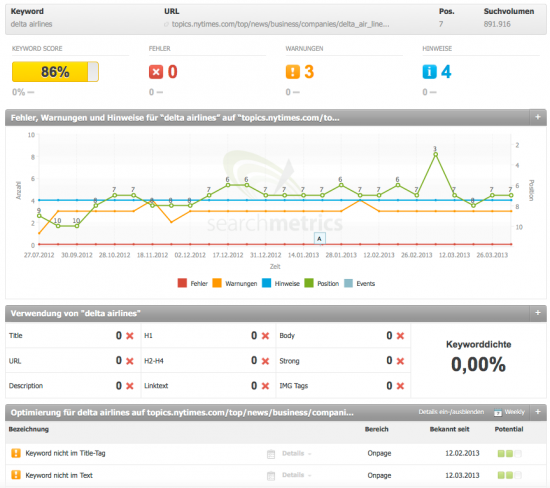

Schaut man sich die Details zu einer solchen Analyse an, wird man schnell fündig.

Oben im Bild sind das Keyword, die URL, die aktuelle Position und das Suchvolumen zu finden. Darunter sehen wir alle Daten über Fehler und Warnungen ‒ aggregiert in einem Keyword-Score. In diesem Beispiel ist die Lösung übrigens recht einfach: Der Grund, warum die URL nicht optimal ist, liegt an der Schreibweise: Während die Google-User nach dieser Fluglinie mit “Delta Airlines” suchen, nennt diese sich “Delta Air Lines”.

Doch das ist eher der Ausnahmefall: meist deckt die Keyword Optimization großes Optimierungs-Potential auf, indem einfach nur das Keyword noch mit in die Headline oder in den Text geschrieben wird. Je, nachdem wo es fehlt. Ein weiterer Punkt ist aber auch die Verwendung des Keywords in internen Links auf diese Seite. Auch dies prüft der Searchmetrics Crawler: Hilft die interne Verlinkung dieser URL beim Ranking? Mit bloßem Auge und ohne einen Crawler ist so etwas niemals zu erkennen.

Übrigens: Falls die gewünschte Landingpage (noch) nicht das höchste Ranking hat, kann diese für den Crawler auch recht einfach definiert werden. Dann zeigt die Keyword Optimization, was noch passieren muss, damit diese URL für das Keyword rankt.

Tipp: Schwellen-Keywords und Absteiger

Auch hier gilt natürlich, dass diese Detail-Arbeit niemals vollständig erledigt werden kann. Deshalb empfehle ich hier, vor allem bei den Schwellen-Keywords (also Suchbegriffe auf den Positionen 10 bis 20) und den Absteigern der Woche einmal genauer zu schauen, was beim Keyword-Targeting noch helfen könnte.

Der OnPage-Trick: Detailarbeit, gut gewichtet

OnPage SEO ist Detail-Arbeit. Deshalb ist es wichtig, diese nicht unnötig kompliziert und unnötig Detail-versessen zu erledigen. Das ist der Grund, warum wir mit Indices, Suchvolumen, Relevanz-Angaben und anderen Sortierhilfen, die wichtigen Arbeiten von den unwichtigen trennen. Nur so ist es möglich, bei einer großen Webseite nicht nur die Dinge richtig zu tun ‒ sondern auch die richtigen Dinge.

Nächste Woche berichten wir über: Return On Invest: Auf die Conversion achten.

Serie: Wie Top-Unternehmen mit Big Data im SEO umgehen

Auf unserer Website kannst Du jetzt auch das komplette eBook mit den unten folgenden Kapiteln erhalten. Jetzt herunterladen!

- Produktivität fördern: Internationale Teams und Agenturen steuern. Große Datenmengen benötigen eine sehr feine Rechteverteilung. Einerseits aus datenschutzrechtlichen Gründen. Aber auch aus Qualitäts-Gründen: Denn wenn jeder machen kann, was er will, ist am Ende nicht mehr klar, was im großen Big-Data-Topf drin ist. Mit der Suite lassen sich diese Aufgaben dank der Rechteverwaltung sehr einfach und übersichtlich lösen.

- Schnelle Übersicht: Strukturiert verschiedene Kampagnen steuern. Große Unternehmen verfolgen jederzeit mehrere Ziele gleichzeitig. Diese Ziele können über die Funktionen der Searchmetrics Suite einzeln verfolgt werden. Dazu gehört das Tagging und Multi-Tagging. Aber auch jeder Report und sogar jedes Chart kann angepasst und automatisiert werden.

- Wettbewerb beobachten: Lerne von der Konkurrenz. Die größte Überraschung im Online-Marketing ist manchmal der Wettbewerb. Denn wer Offline zu unserer Konkurrenz zählt, ist online möglicherweise nur eine Randerscheinung während die Offline-Partner sogar die härtesten Wettbewerber sind. Wir liefern auf gleich mehreren Datenpools das jeweils richtige Umfeld.

- Pick the Cherrys: versteckte Potentiale nutzen. Nicht immer lohnt es sich, an den Keywords mit dem größten Suchvolumen zu arbeiten. Eine wichtige Rolle spielen der Wettbewerb, die Universal Search und schon vorhandene Rankings.

- Performance verbessern: Die technische Optimierung. Bei einer großen Seite geht selbst dem besten SEO der Überblick verloren. Wir crawlen jede Seite und liefern Fehlerseiten und Optimierungs-Potential für Keywords.

- Return On Invest: Auf die Conversion achten. Am Ende geht es ums Geld. Lohnt sich eine PPC-Kampagne oder soll das Budget doch lieber in eine SEO-Optimierung wandern? Was lohnt sich mehr? Wir liefern Zahlen für diese Entscheidung.

- Prozesse optimieren: Zeit und Geld sparen. Der eine Mitarbeiter im Team braucht einen täglichen Report, der andere eine monatliche Zusammenfassung. Unsere Reports sind extrem flexibel, vielsagend und werden mit wenigen Klicks zusammengebaut.

Ihr seht: Es gibt viel zu tun. Big Data ist weder ein Marketing-Hype noch ein einfacher Blick in eine mit Daten gefüllte Glaskugel. Big Data ist eine notwendige und effektive Arbeitsweise, die einfach zum Enterprise-SEO gehört und die gelernt werden muss. Wir helfen dabei.