In den letzten Wochen gab es wieder einige Bewegung in den Ranking-Daten, die zuletzt in einigen sehr eindeutigen Ausschlägen Ende der vergangenen Woche (KW 6/2017) gipfelten. Es gibt teilweise Schwankungen und Hinweise, die in Richtung Mobile gehen, sodass Spekulationen über ein eventuell erfolgtes Rollout von “Mobile-First” die Runde machen. Auch ein Impact der Herabstufung von Seiten, die Interstitals beim Aufrufen über Mobile Devices einblenden, wurde vermutet. Angesichts der betroffenen Seiten sehen wir hingegen ein bekanntes Muster, das auf ein weiteres Phantom-Update hindeutet.

Damit wäre es mittlerweile die fünfte Rückkehr des Phantoms. Warum wir das vermuten? Ganz einfach: Unter den betroffenen Seiten sind sehr viele Domains, die wir schon aus den bisher erfolgten Analysen zu Phantom-Updates kennen. Charakteristisch im Muster sind hier die länger andauernden Schwankungen, keine pauschalen Verlierer nach Branchen-Zugehörigkeit, sowie ein Auf-und-Ab für viele Seiten – je nach Iteration. Angesichts dieser Achterbahnfahrten kann man sich durchaus fragen: Was will Google eigentlich?

Google Phantom Updates – Was bisher geschah

Womit sich das – bisher nicht offiziell von Google bestätigte – Phantom Update und seine (bisher 4) Iterationen von Google beschäftigt, haben wir in unseren letzten Beiträgen zum Thema schon des Öfteren ausführlich dargelegt. Hier noch einmal eine kleine Übersicht.

- Phantom I – (Mai 2013)

- Phantom II – (Mai/Juni 2015)

- Phantom III – (November 2015)

- Phantom IV – (Juni/Juli 2016)

Was fällt auf? Bei dem zunächst auch oft als “Quality Update” bezeichneten Update scheint sich zuletzt ein regelmäßiger Halbjahres-Rhythmus eingestellt zu haben. Interessant ist dabei, dass regelmäßig bekannte Gesichter unter den Gewinnern und Verlierern anzutreffen sind – die jedoch nicht über einen kontinuierlichen Abwärts- oder Aufwärts-Trend, sondern ein stetiges Hin-und-Her auffallen.

Korrigiert Google hier kontinuierlich etwaig begangene “Fehler”? Dieses Hin-und-Her spricht dafür, dass die Suchmaschine mit den erzielten Auswirkungen der jeweiligen Updates nicht zufrieden ist. Leidtragende sind die Domains, die – zumindest für einen bestimmten Zeitraum – unter teilweise erheblichen Visibility-Einbußen leiden müssen.

SEO Visibility vs. Traffic – tatsächliche Auswirkungen unterscheiden sich

Auf der anderen Seite hört man von einigen Seitenbetreibern, dass die Schwankungen Seitenbereiche bzw. Rankings auf für Traffic irrelevanten Keywords betreffen, und somit ein Großteil des relevanten Traffics vom Phantom gar nicht – oder nur minimal – betroffen ist, auch wenn die SEO Visibility teilweise deutliche Ausschläge aufweist.

Das kommt natürlich darauf an, worüber man den Traffic bekommt. Das Phantom jedenfalls konzentriert sich in der Regel auf hochvolumigen Shorthead und Brand-Keywords.

Worauf zielt das Phantom ab?

Der Fokus der Phantom-Updates war zwar bislang – und ist auch jetzt nicht – trennscharf abzugrenzen, aber dennoch lassen sich einige Muster und Charakteristika des Filters erkennen, die immer wiederkehren. Diese sind eher “weiche Faktoren” zur Bewertung einer Seite – und gerade deshalb wohl (auch für Google) so schwer zu definieren. Eine kurze Zusammenfassung der wichtigsten wiederkehrenden Beobachtungen:

- im Fokus steht die “Qualität” von Online-Inhalten (die komplex bewertet werden kann/muss)

- das Update arbeitet seitenbasiert – einzelne Seiten und/oder Verzeichnisse sind betroffen, nicht ganze Domains

- das Rollout zieht sich oft über mehrere Wochen hin

- oft sind große Brands unter den Gewinnern/Verlierern

- Domains sind oft mehrmals von verschiedenen Updates betroffen – allerdings als Gewinner und Verlierer

- Die Gewinne/Verluste spielen sich häufig auf Brand- und/oder Shorthead-Keywords ab

- User Signale scheinen eine Rolle bei der Bewertung zu spielen – die Nutzerintention steht im Vordergrund

Aktuelle “Gewinner und Verlierer” von Phantom 5

Schauen wir uns einige Seiten an, die von der aktuellen Phantom-Iteration betroffen sind. Einen besonderen Blick widmen wir hierbei den “alten Bekannten” aus vorigen Phantom Updates.

Verlierer des Google Phantom V Updates:

12gebrauchtwagen.de (Phantom 4 Gewinner)

pcwelt.de (Phantom 4 Gewinner)

daskochrezept.de (Phantom 4 Gewinner)

dielottozahlende.net (Phantom 3 Gewinner)

schlafwelt.de (Phantom 4 Verlierer)

Gewinner des Google Phantom V Updates:

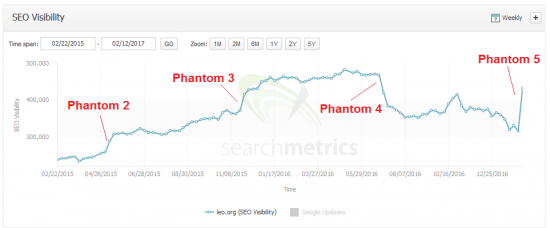

leo.org (Phantom 4 Verlierer)

idealo.de (Phantom 4 Verlierer)

billiger.de (Phantom 4 Verlierer)

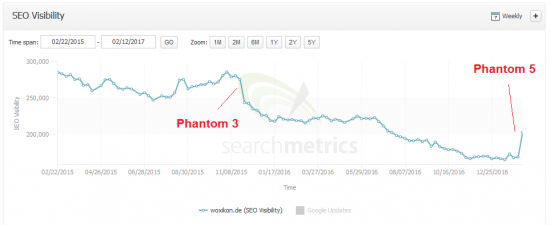

woxikon.de (Phantom 3 Verlierer)

onmeda.de (Phantom 4 Verlierer)

Hier wird die Achterbahnfahrt besonders deutlich. Verlierer > Gewinner > Verlierer > jetzt wieder Gewinner.

An den Kurven wird eines deutlich: Im Gegensatz zu früheren Phantom Updates, bei denen der Filter über mehrere Wochen ausgerollt wurde, sind diesmal die Ausschläge insbesondere im Vergleich zur Vorwoche, sehr ausgeprägt. Ob und wie es weitere Auswirkungen gibt, bleibt abzuwarten.

Auswirkungen auch bei bisher nicht vom Phantom betroffenen Domains:

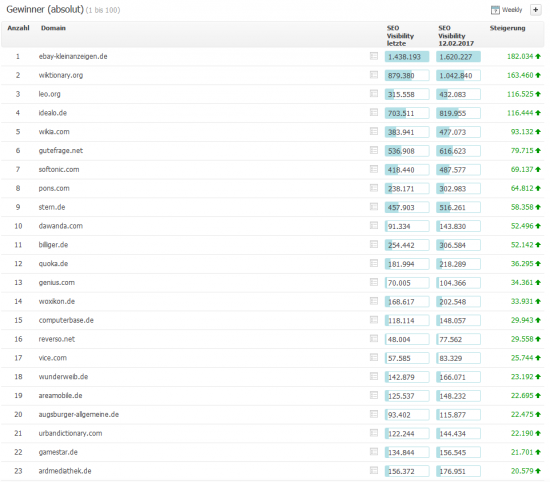

Darüber hinaus sind auch ein paar bislang nicht vom Phantom affektierten Seiten unter den Seiten mit Ausschlägen in der SEO Visibility. So ist ebay-kleinanzeigen.de zum Beispiel der Top-Gewinner (nach absolutem Gewinn). Generell befinden sich einige Domains aus dem Bereich E-Commerce in den Gewinner- und Verliererlisten. Allerdings mag dies daran liegen, dass Brand- und Shorthead-Keywords betroffen werden, und nicht weil Phantom explizit auf die E-Commerce-Branche abzielt. Insgesamt lesen sich die Gewinner der aktuellen Woche jedoch wie eine Auswahl der bisherigen Domains im Phantom-Fokus:

Reddit.com dagegen hat (auch in den USA) einen ziemlich hohen prozentualen Verlust von-22% zu verzeichnen – und weist zudem einen merkwürdigen Verlauf der Mobile SEO Visibility (grün) auf, der vor dem letztendlichen Absturz auffällt. Ob hier ein Zusammenhang zu “Mobile-First” vorliegt, ist jedoch fragwürdig und bleibt abzuwarten. Als durchgängiges Muster lässt sich dies jedenfalls nicht erkennen. Im Fall von Reddit könnte das unter Umständen eher an (technischen) Problemen mit der Mobilseite liegen.

Dagegen fallen sehr wohl als Muster (nicht häufig, aber auch nicht als Einzelfall) Kurven wie die von linguee.com auf, bei denen die Visibility über die letzten Wochen erst gestiegen, und nun wieder auf den Ursprungswert zurückgegangen ist.

Sieht aus, als hätte Google hier getestet. Im US-Index Google.com ist dieses Muster übrigens deutlich präsenter.

Sieht aus, als hätte Google hier getestet. Im US-Index Google.com ist dieses Muster übrigens deutlich präsenter.

Fazit: Google-Achterbahn für Brands auf Marken- und Shorthead-Keywords

Google scheint echte Probleme bei der Relevanzbewertung für größere Seiten zu haben, wenn es um Brand- und Shorthead-Keywords geht. Es sieht so aus, als würden hier in regelmäßigen Abständen die Stellschrauben zur Qualitätseinstufung justiert werden, was zur Folge hat, das die SEO Visibility der betroffenen Domains von teilweise sehr starken Schwankungen betroffen ist. Diese dürften das einerseits nicht gerade lustig finden, WENN es sich dabei um für sie relevante Keyword-Rankings und damit relevanten Traffic handelt. Denn andererseits ist es für einige betroffene Brands eben auch nicht sinnvoll, beispielsweise für fremde Markennamen zu ranken, der sich zwar in einer höheren SEO Visibility wiederspiegelt, aber sich daraus für sie kein relevanter Traffic ergibt. Eben genau das könnte Google auch herauszufinden versuchen.

Wir sind gespannt, wie die Achterbahnfahrt weitergeht, ob sie ein Ende haben wird und freuen uns natürlich über Kommentare – insbesondere über Insights zu Auswirkungen auf den realen Traffic.